Полное руководство по дублированному контенту в SEO

В статье — что такое дублированный контент, почему он появляется и как влияет на SEO. А также советы, что с ним делать.

❗️ Это перевод и адаптация статьи Стивена ван Вессума для Conductor.com.

Что такое дублированный контент и чем он плох для SEO

В узком смысле дублированный контент — это очень похожий или идентичный контент, размещённый на разных страницах вашего или других сайтов.

В широком смысле это контент, который не несёт никакой ценности для ваших посетителей. Поэтому страницы, на которых практически отсутствует содержимое (в теге <body/>), также считаются дубликатами.

К недостаткам дублированного контента можно отнести следующее:

-

При наличии нескольких версий контента поисковым системам трудно определить, какую из них надо проиндексировать и впоследствии показать в результатах поиска. Это снижает производительность всех версий контента, которым приходится конкурировать друг с другом.

-

У поисковых систем могут возникнуть проблемы с закреплением метрик ссылок (авторитет, значимость и доверие) для контента. Особенно когда другие сайты ссылаются на более чем одну версию этого контента.

💬 Барри Адамс, эксперт по новостному SEO:

Дубликаты вызывают серьёзные проблемы с SEO и посылают конфликтующие сигналы поисковым системам. У вашего контента должны быть уникальные URL‑адреса, и сам контент должен быть уникальным. Каждая страница так будет иметь больше шансов на высокий рейтинг и привлечение трафика.

Существуют ли санкции за дублированный контент

Дублированный контент может повредить поисковой оптимизации, но вы не получите штраф от Google до тех пор, пока не копируете чей‑то сайт умышленно. Если же вы скопировали большое количество чужого контента, то есть риск санкций.

💬 Вот что говорит Google на этот счет:

«Наличие дублированного контента на сайте не является основанием для наложения санкций, если только не выясняется, что за этим стоит намерение обмануть и манипулировать результатами поисковой системы. Если ваш сайт содержит дублированный контент и вы не следуете описанным выше советам, мы самостоятельно выберем версию контента для показа в поисковой выдаче».

А вот что говорят эксперты в этой отрасли:

💬 Пол Шапиро, глава технического отдела SEO и управления SEO‑продуктами в Shopify:

«Зачастую люди заблуждаются насчет дублированного контента.

На самом деле наличие одной или двух малозначимых страниц, содержащих дублированный контент, не так страшно. Реальная угроза возникает, когда сайт генерирует многочисленный дублированный контент по причине плохой веб‑разработки и технических проблем SEO. Это может привести к сложностям со сканированием и трафиком на сайте. Вызывают опасение и ситуации, когда другой домен крадёт ваш контент и эти страницы ранжируются выше ваших. Подобное происходит редко, но бывает.

И наконец, пожалуй, самый большой недостаток дублированного контента заключается в разбавлении обратных ссылок. Если у меня есть две версии одной страницы и пользователи не знают, какая из них является основной, то одна может получить обратные ссылки, а другая нет. Таким образом, вместо одной страницы со всеми обратными ссылками она будет разделена на две или более страниц. Это вредно для сайта».

💬 Патрик Стокс, технический SEO‑специалист:

«25–30 % веб‑контента является дублированным, и в этом нет ничего плохого! Вас никто не накажет за это, и Google решит проблемы с дублированием на сайте. Я бы не стал из‑за этого слишком переживать, если, конечно, речь не идёт о намеренной краже чужого контента, что может привести к серьёзным проблемам».

Как чаще всего решают проблему дублированного контента

В большинстве случаев лучшим решением проблемы дублированного контента является 301‑редирект с нецелевых версий URL‑адресов на целевые.

Если URL‑адреса должны оставаться доступными для посетителей, использовать редирект уже нельзя. Здесь на помощь придут либо канонические теги, либо директива robots noindex. Канонический URL позволяет объединять сигналы, а как директива robots noindex — нет.

Тщательно выбирайте средство для борьбы с дублированным контентом, поскольку все они имеют свои преимущества и недостатки. В этом случае нет универсального подхода, который автоматически устранил бы все проблемы.

Почему возникает дублированный контент

Как правило, дублированный контент возникает по причине некорректной настройки веб‑сервера или сайта. Это технические проблемы, которые, скорее всего, никогда не приведут к штрафу от Google. Тем не менее они могут нанести серьезный ущерб рейтингу сайта в выдаче.

Помимо проблем технического характера, существуют и те, которые были вызваны человеком — речь о намеренно скопированном контенте. Как было сказано ранее, если в подобных действиях есть злой умысел, это может повлечь за собой санкции от ПС.

Технические причины

1. Сайт с www vs без и HTTP vs HTTPs

Представим, что вы используете поддомен www и HTTPs‑соединение. Тогда предпочтительный способ представления контента будет выглядеть следующим образом:

https://www.example.com.

Это ваш канонический домен.

Если веб‑сервер плохо настроен, содержимое сайта также может быть доступно по другим доменам:

Все эти домены для Google и других ПС — разные сайты. При этом на них один и тот же контент.

Выберите предпочтительный способ представления контента пользователю и внедрите редирект‑301 для нежелательных способов. Они должны вести к предпочтительной версии:

https://www.example.com

2. Структура URL: регистрозависимость и завершающий слеш

В Google URL‑адреса чувствительны к регистру. Это означает, что https://example.com/url‑a/ и https://example.com/url‑A/ рассматриваются как разные URL.

При создании ссылок легко допустить опечатку, что приведёт к индексации обеих версий URL. При этом в Bing, например, URL‑адреса нечувствительны к регистру. А Яндекс тоже чувствителен к регистру URL.

Косая черта (/) в конце URL‑адреса называется завершающим слешем. Часто URL‑адреса доступны через оба варианта: https://example.com/url‑a и https://example.com/url-a/.

Дублированный контент, вызванный несоответствием в регистре URL‑адресов и использованием завершающей косой черты

Выберите предпочтительную структуру для своих URL‑адресов, а для непредпочтительных — реализуйте 301‑редирект на предпочтительную версию.

💬 Гамлет Батиста, генеральный директор RankSense:«Объединение дублированного контента — это не вопрос о том, как избежать санкций Google. Речь о создании ссылок. Ссылки крайне важны для SEO‑производительности, но если они оказываются на дублированных страницах, то не принесут никакой пользы, а просто пропадут даром».

Ставить завершающий слеш в URL или нет: как лучше для SEO

3. Индексные страницы (index.html, index.php)

Домашняя страница вашего сайта может быть доступна через множество URL‑адресов. А всё дело в неправильной конфигурации веб‑сервера. Помимо https://www.example.com, она может быть также доступна через:

-

https://www.example.com/index.html

-

https://www.example.com/index.asp

-

https://www.example.com/index.aspx

-

https://www.example.com/index.php

Сделайте 301‑редирект от всех нецелевых версий на целевую. Если все эти адреса используются для предоставления контента, то канонизируйте эти страницы.

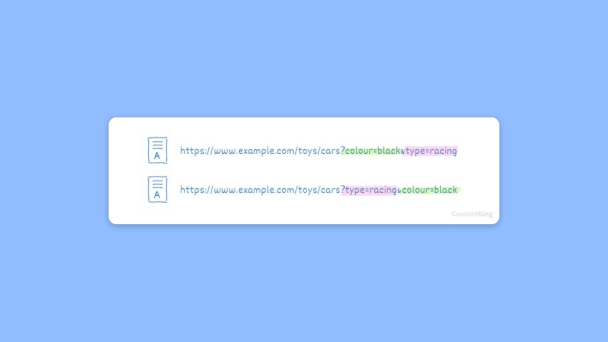

4. Параметры для фильтрации

Веб‑сайты часто используют в URL‑адресах параметры, чтобы обеспечить функциональность фильтрации. Возьмем, к примеру, следующий URL:

https://www.example.com/toys/cars?colour=black

На данной странице отобразятся все чёрные игрушечные машинки.

В то время как пользователей устраивает результат на этой странице, у ПС могут возникнуть большие проблемы. Параметры фильтрации часто создают практически бесконечное количество комбинаций, когда доступно более одного варианта фильтрации. Ещё параметры можно менять местами.

По этим двум URL‑адресам пользователи увидят абсолютно идентичный контент:

Внедрите канонические URL‑адреса — по одному для каждой главной страницы — для предотвращения дублирования контента и укрепления авторитета страницы, прошедшей фильтр.

Canonical: что это за атрибут и как прописать канонический адрес страницы

Только обратите внимание: это не защитит вас от траты краулингового бюджета. В качестве альтернативы можно использовать функциональность обработки параметров в Google Search Console и Bing Webmaster Tools, чтобы проинструктировать краулеры о том, как работать с параметрами.

💬 Дженни Халас, руководитель SEO в LL Flooring:

«Дублирование контента — это наиболее распространенная и непонятая SEO проблема. Существует такое множество форм дубликатов, которых следует остерегаться. И малейшая техническая ошибка может привести к буквально тысячам дублированных страниц.

Мне приходилось наблюдать, как успешные сайты оказывались в тупике из‑за дублированного контента. Одно только устранение проблем, приводящих к появлению дублированного контента, часто может привести к увеличению органического трафика более чем на 20 %. Если ваш сайт посещают миллионы пользователей, то это может принести сотни тысяч долларов дополнительных доходов».

5. Таксономии

Таксономия — механизм группировки для классификации контента. Он часто используется в системах управления контентом для поддержки категорий и тегов.

Представим, у вас есть запись в блоге, относящаяся к трем категориям. Запись может быть доступна во всех трех категориях:

-

https://www.example.com/category‑a/topic/

-

https://www.example.com/category‑b/topic/

-

https://www.example.com/category‑c/topic/

В этом случае нужно выбрать одну из этих категорий в качестве главной, а остальные канонически привязать к ней, используя канонический URL.

💬 Давид Иванов, директор отдела поиска в Reckitt:

«Дубликаты — это серьезная проблема для многих устаревших платформ, которые сильно зависят от параметров внутренней структуры страниц. Но это также и проблема новых платформ, таких как WordPress, с тегами и страницами, которые часто лучше не индексировать с самого начала».

6. Специальные страницы для изображений

Некоторые CMS создают отдельную страницу для каждого изображения. На этой странице часто просто отображается изображение и больше ничего. Поскольку на странице нет другого контента, она очень похожа на все остальные страницы с изображениями. ПС видят её как дублированный контент.

Если это возможно, отключите функцию выделения специальных страниц для изображений. Если такой возможности нет, то лучше всего добавить атрибут meta robots noindex на такие страницы, чтобы ПС их не индексировали.

7. Страницы комментариев

Если у вас на веб‑сайте включены комментарии, вы можете автоматически разбивать их на страницы по истечении определенного времени. Страницы с постраничными комментариями будут отображать оригинальное содержимое, только комментарии внизу будут отличаться.

Например, URL‑адрес статьи, в которой показаны комментарии 1–20, может быть таким:

https://www.example.com/category/topic/,

https://www.example.com/category/topic/comments‑2/ — для комментариев 21–40

https://www.example.com/category/topic/comments‑3/ — для комментариев 41–60.

Используйте связи ссылок с пагинацией, чтобы указать, что это серия страниц с пагинацией.

Что такое пагинация и как она работает

8. Локализация и атрибут hreflang

Когда речь идет о локализации страниц для разных аудиторий, тоже могут возникнуть проблемы с дублированием контента — когда вы используете один и тот же контент для людей в разных регионах, говорящих на одном и том же языке.

Например, у вас есть сайт, ориентированный на канадский рынок, и сайт для рынка США. Поскольку оба представлены на английском языке, существует высокая вероятность дублированного контента.

Google хорошо это определяет и, как правило, сам сводит эти результаты воедино. Атрибут hreflang помогает предотвращать дублирование контента. Поэтому, если у вас один и тот же контент для разной аудитории, обязательно используйте атрибут hreflang в рамках международной SEO‑стратегии.

9. Индексируемые страницы результатов поиска

Многие сайты позволяют пользователям осуществлять поиск по содержимому. Все страницы, на которых отображаются результаты поиска, очень похожи между собой и в большинстве случаев не несут никакой ценности для поисковых систем. Едва ли вам захочется, чтобы они индексировались поисковиками.

Предотвратить индексацию страниц с результатами поиска можно путем использования атрибута meta robots noindex. И вообще лучше всего не ссылаться на страницы с результатами поиска.

В случае большого количества страниц с результатами поиска, сканируемых поисковыми системами, рекомендуется в первую очередь запретить поисковикам доступ к ним, используя файл robots.txt.

Как закрыть сайт от индексации в robots.txt

- Индексируемая промежуточная/тестовая среда

Также рекомендуется использовать промежуточные среды для развёртывания и тестирования новых функций на веб‑сайтах. Но их часто ошибочно оставляют доступными для поисковых систем.

Используйте HTTP‑аутентификацию, чтобы закрывать доступ к промежуточным/тестовым средам. Дополнительное преимущество этого способа ещё в том, что вы так закрываете доступ к сайту и мошенникам.

- Контент на стадии разработки

Создавая новую страницу с небольшим количеством контента, сохраните её, но не публикуйте. Зачастую она не представляет особой ценности.

Сохраняйте незавершённые страницы как черновики. Если вам действительно необходимо опубликовать страницы с недостаточным содержанием, запретите поисковым системам индексировать их — используйте атрибут meta robots noindex.

- Параметры, которые используются для отслеживания (UTM‑метки)

Параметры в URL также часто используются в целях отслеживания. Например, при публикации URL‑адресов в Twitter к URL‑адресу добавляется источник в виде UTM. Такие параметры в URL‑адресах тоже ведут к созданию дублей. Например, вот так будет выглядеть URL‑адрес, опубликованный в Twitter при помощи Buffer:

https://www.contentkingapp.com/academy/ecommerce-link-building/?utm_content=buffer825f4&utm_medium=social&utm_source=twitter.com&utm_campaign=buffer

Чтобы избежать дублей в этом случае, нужно внедрять канонические URL‑адреса с автореферентными ссылками на такие страницы.

- Идентификаторы сессий

Сессии могут хранить информацию о посетителях для веб‑аналитики. Если к каждому URL‑адресу, который запрашивает посетитель, добавляется идентификатор сессии, это приводит к появлению большого количества дублированного контента, поскольку содержимое этих URL‑адресов идентично.

Когда вы переходите по ссылке на локализованную версию сайта, в неё добавляется переменная сессии Google‑аналитики. Это может выглядеть так:

https://www.contentking.nl/?_ga=2.41368868.703611965.1506241071‑1067501800.1494424269.

Она показывает домашнюю страницу с точно таким же содержимым, только по другому URL‑адресу.

В этом случае лучшим решением тоже будет внедрить на страницах автореферентные канонические URL.

- Удобная для печати версия

Когда страницы имеют удобную для печати версию по отдельному URL‑адресу, по сути, опять существуют две версии одного и того же контента. Представьте:

https://www.example.com/some‑page/

и

https://www.example.com/print/some-page/.

Реализуйте канонический URL‑адрес, ведущий от версии, удобной для печати, к обычной версии страницы.

Копирование контента

1. Целевые страницы для платного поиска

Платный поиск требует специальных целевых страниц, ориентированных на определённые ключевые слова. Целевые страницы зачастую являются копиями исходных страниц, которые затем настраиваются на конкретные ключевые слова. Поскольку эти страницы очень похожи, они создают дублированный контент, если индексируются поисковыми системами.

Запретите поисковым системам индексировать целевые страницы, внедрив атрибут meta robots noindex. Лучше всего не ссылаться на целевые страницы и не включать их в XML‑карту сайта.

2. Другие сайты, копирующие ваш контент

Дублированный контент может также возникнуть по причине того, что другие сайты копируют и публикуют ваш контент у себя или где‑то ещё.

Особенно остро эта проблема стоит, если ваш сайт имеет низкий авторитет домена (Domain Authority, DA), а тот, кто копирует ваш контент, обладает более высоким DA. Такие сайты чаще сканируются, и в результате скопированный контент сначала сканируется на веб‑сайте того, кто скопировал контент. Он может восприниматься ПС как автор оригинала и занимать более высокое положение в выдаче.

Позаботьтесь, чтобы владельцы других сайтов отдавали вам должное, внедрив канонический URL‑адрес, ведущий на вашу страницу, и ссылку на вашу страницу. Если они не хотят этого делать, вы можете отправить запрос DMCA в Google или даже подать в суд.

3. Копирование контента с других сайтов

Копирование контента с других сайтов — ещё одна форма дублированного контента. Google пишет, что лучший способ справиться с этой проблемой с точки зрения SEO — ссылка на исходный источник в сочетании либо с каноническим URL, либо с метатегом robots noindex.

Как искать дублированный контент

На своём сайте

Автор оригинальной статьи рассказывает о том, как работать с ContentKing, чтобы искать дубли, а мы покажем, как делать это в Анализе сайта от Топвизора.

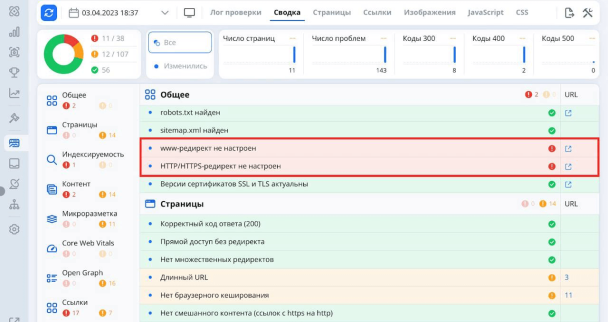

1. Запустите Анализ сайта, загрузив нужные URL.

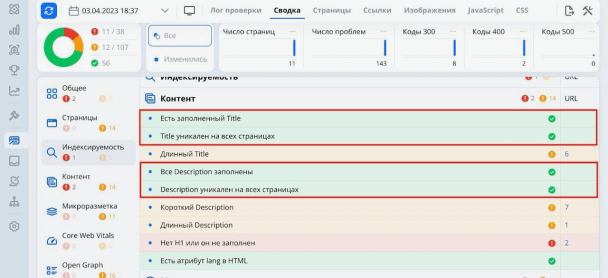

2. Посмотрите сводку по проверке, когда анализ закончится. В ней есть несколько пунктов, которые могут сказать о дублях на сайте:

3. Если не настроены www‑редиректы, возможно, сайт показывается по адресу с www и без www. Для ПС это две разные версии сайтов, которые являются дублями.

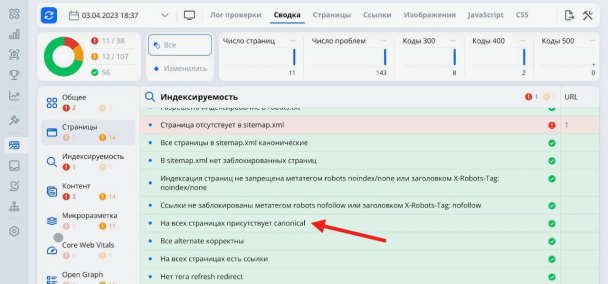

4. В разделе «Индексируемость» можно увидеть, есть ли на страницах сайта canonical:

5. Наконец, в разделе «Контент» сводки можно увидеть, не дублируется ли содержимое тегов title и description на страницах сайта:

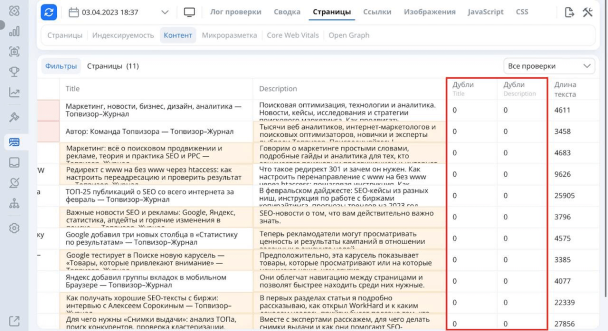

Ещё дубли title и description можно увидеть в отчёте «Страницы» — «Контент»:

Отчёт Google Search Console об охвате индекса также пригодится при поиске дублированного контента на сайте. Обращайте внимание на следующие проблемы:

-

Дубликат, пользователь не выбирал каноническую страницу: Google обнаружил дубликаты URL‑адресов, которые не канонизированы до предпочтительной версии.

-

Дубликат страницы, Google выбрал страницу вместо той, что выбрал пользователь: Google решил проигнорировать ваши канонические URL‑адреса, которые он самостоятельно нашел, и вместо этого присваивает выбранные Google страницы.

-

Дубликат, представленный URL, не выбран в качестве канонического: Google решил проигнорировать канонические страницы, которые вы определили для URL‑адресов, отправленных вами через XML‑карту сайта.

Что такое Google Search Console: как подключить и настроить

В Вебмастере тоже можно увидеть эти данные — в отчётах вкладки «Индексирование».

Как использовать Яндекс Вебмастер

На других сайтах

Если у вас маленький сайт, вы можете попробовать поискать в Google фразы в кавычках. Например:

"Используя ContentKing, вы с легкостью найдете дублирующийся контент, проверив, есть ли на ваших страницах уникальное название, метаописание, и заголовок H1".

Введя подобную фразу в поиск, можно увидеть дубли.

В качестве альтернативы для больших сайтов можно использовать Copyscape. Он просматривает веб‑страницы в поисках нескольких повторений одного и того же или почти одинакового содержимого.

FAQ по дублированному контенту

Могут ли на сайт наложить санкции за дублированный контент

Если у вас не было намерений полностью копировать чей‑то сайт, то, скорее всего, на вас не наложат санкции. Если же вы скопировали большое количество чужого контента, то такой риск есть.

💬 Вот что говорит об этом Google:

«Дублированный контент на сайте не является основанием для действий в отношении этого сайта, если только не выясняется, что за дублированным контентом стоит намерение обмануть и манипулировать результатами поисковой системы.

Если ваш сайт содержит дублированный контент и вы не следуете описанным выше советам, мы самостоятельно выберем версию контента для показа в поисковой выдаче».

Повысит ли устранение проблем с дублированным контентом рейтинг сайта в выдаче

Да, устраняя проблемы с дублированием контента, вы сообщаете ПС, какие страницы действительно следует сканировать, индексировать и ранжировать.

Вы также не позволите поисковым системам тратить краулинговый бюджет на изучение вашего сайта на предмет нерелевантных дублированных страниц. Они могут сосредоточиться на уникальном контенте, по которому вы хотите ранжироваться.

Какое количество дублированного контента на сайте допустимо

На этот вопрос нет единственно правильного ответа. Однако если вы хотите повысить рейтинг страницы, она должна быть ценной для ваших посетителей и содержать уникальный контент.

👇 Ещё по теме

Как оптимизировать краулинговый бюджет