Как бороться с накруткой поведенческих факторов

Что такое «накрутка пф». Как обнаружить и как бороться с накруткой поведенческих факторов, если конкуренты крутят ПФ. Ответ Яндекса о накрутках и реальные кейсы SEO-специалистов.

Накрутка поведенческих факторов — это манипуляция результатами поиска и нарушение правил. За это поисковые системы накладывают санкции: понижают видимость сайта и исключают его из поискового индекса.

Раньше конкуренты пользовались этим так: накручивали отрицательные ПФ ботами топовым сайтам и ждали, когда те получат санкции и вылетят из ТОПа. Сейчас по-другому: имитируют заходы с короткими сессиями. У страниц растёт показатель отказов и это негативно влияет на ранжирование сайта.

Можно ли с этим бороться и как, расскажет SEO-специалист Станислав Жуковский. Ещё в статье мы приводим мнения экспертов, кейс и ответ техподдержки Яндекса о накрутках.

Что такое накрутка поведенческих факторов

Если пользователи часто заходят на сайт, просматривают страницу, оставляют заявки, переходят по ссылкам, нажимают на кнопки — это значит, что у сайта хорошие поведенческие факторы (ПФ).

Этот показатель влияет на ранжирование, особенно в Яндексе. Сайты с хорошими ПФ поисковая система оценивает лучше и даёт высокие позиции в выдаче. Когда оптимизаторы это поняли, то стали предлагать продвижение сайта в ТОП Яндекса поведенческими факторами: заказывать искусственный трафик на сайт ботами или людьми, которые имитируют поведение реальных пользователей.

Но накрутка какого-либо фактора ранжирования — это попытка искусственно повлиять на поиск, что нарушает правила поисковых систем. Если сайт замечен в подобной накрутке, то его могут понизить или исключить из выдачи на долгое время — 8-12 месяцев.

У накрутки поведенческих сейчас два применения. Первое — когда нужно быстро «поднять» молодой сайт, но нет времени и ресурсов на «белые» методы SEO. Второе — «завалить» конкурентов.

«Завал» может преследовать одну из двух целей: в целом ухудшить положение конкурента в поиске или чтобы накрутка поведения на своём сайте сработала лучше.

Как накручиваются поведенческие факторы

Накрутки делятся на два вида: нативные (человеческие) и RPA — роботизированные.

Нативные накрутки. Чтобы их заказать, идут на сервис накрутки ПФ, где сидят живые пользователи. Им выдаётся конкретное задание: ввести ключевик в поиске, кликнуть три любых сайта из выдачи, перейти на третью страницу поиска, кликнуть на нужный ресурс, пролистать сайт до такой-то страницы, там пробыть 15 секунд и переключить вкладку — что-то вроде того.

RPA-накрутки. Делаются по тому же сценарию, но действия совершает не человек, а робот по заранее заданным параметрам — есть специальные программы для накрутки поведенческих факторов сайта. Роботизированные накрутки быстрее и дешевле, но они почти всегда помечаются на стороне Яндекса как боты. Поэтому RPA-накрутки почти неэффективны.

Накрутки можно разделить и по цели: поднять сайт или «завалить» конкурента. По этому параметру их делят на позитивные и негативные.

Также накрутку можно классифицировать по тактике — какой именно показатель накручивается:

- CTR;

- поисковые подсказки;

- глубина просмотра;

- время на сайте;

- конкретный запрос.

Как обнаружить

Накрутку ботами можно обнаружить в Яндекс.Метрике и Вебмастере.

Она выглядит как внезапный всплеск трафика и числа пользователей с переходами из социальных сетей и прямых заходов с других сайтов, в то время как раньше это были переходы, например, из поиска. Сейчас прямые накрученные запросы «из поисковика» встречаются редко.

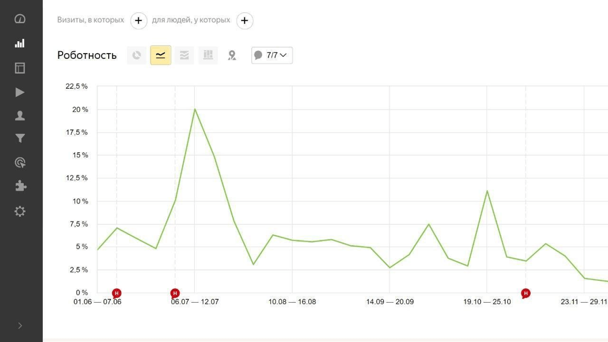

Но Яндекс почти всегда определяет такое посещение как роботное и отсекает его. В аналитике вы увидите резкий рост параметра Роботность:

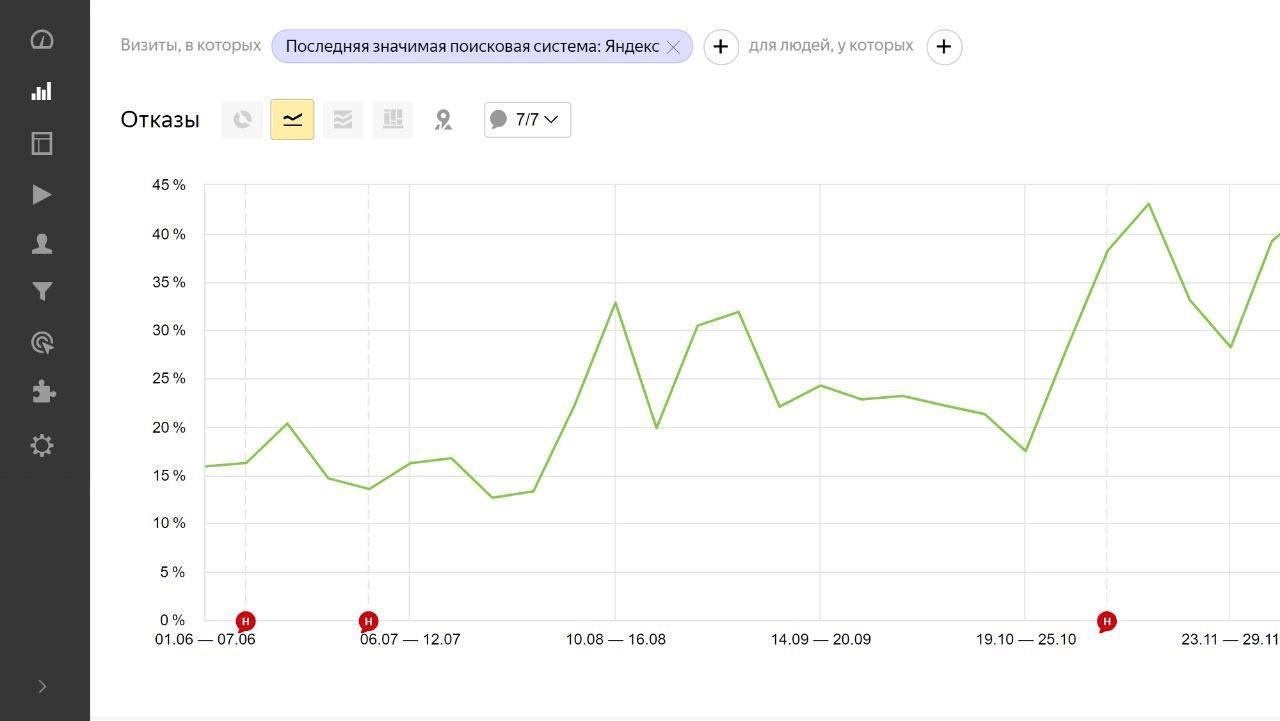

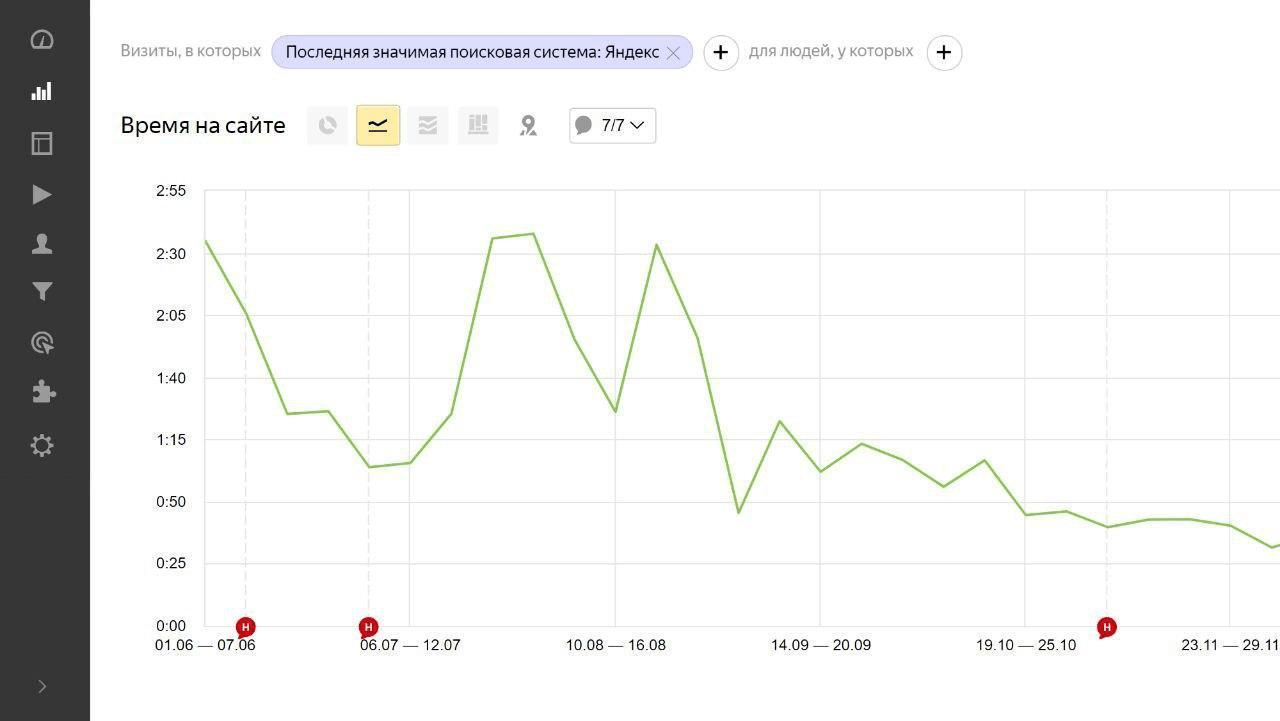

Ещё накрутки можно распознать по уменьшению времени пребывания на сайте и увеличению количества отказов:

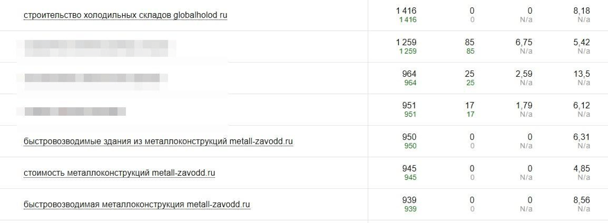

В Вебмастере накрутка определяется по резкому увеличению CTR, а также, когда в популярных запросах появляются запросы типа "запрос + домен сайта":

Последствия накрутки

Накрутку можно обнаружить уже на следующие сутки, когда в Метрике и Вебмастере есть полные данные за прошедший день.

Последствия всегда непредсказуемы: домен может попасть под фильтр, может упасть в поиске, а может и не измениться.

К чему может привести накрутка поведенческих факторов — Яндекс.Справка

Если домен попал под бан-фильтр, видимость сайта будет 0 %. Трафик упадёт в несколько раз, и сайт не попадёт в выдачу.

Если домен упал в поиске на вторую и третью страницы, позиции ещё можно вернуть. Стоимость и период возврата будут зависеть от конкретного сайта.

Что делать, если вам накручивают ПФ

SEO-специалист Станислав Жуковский рассказал два метода, которые позволяют бороться с накрутками. Эффективность для всех сайтов будет разной.

Анти-бот скрипты

Скрипты в однократном режиме за 1-3 секунды автоматически определяют реального пользователя и пропускают его на веб-ресурс. Ботов скрипты отсеивают и не позволяют им посещать сайт.

Можно найти анти-бот скрипт, с которым удобно работать именно вам, или использовать AntiBot.cloud.

Скрип разделяет всех посетителей на 3 группы:

- Белые боты поисковиков, социальных сетей. Они не замечают скрипт и свободно попадают на сайт.

- Живые посетители. Попадают на сайт через 2 секунды после проверки.

- Спам-боты. Отсеиваются скриптом и на сайт не попадают.

AntiBot.cloud — платный скрипт. Облачную версию можно бесплатно протестировать в течение 15 дней.

Недостатки:

- Невозможно рекламировать сайт в Google AdWords. По моему опыту, объявления не проходят техническую модерацию, но с индексацией страниц проблем нет.

- Несовместимость анти-бот скрипта со скриптами кэширования, у которых проверка кэша происходит до проверки АнтиБота для сайте (на уровне NGINX или .htaccess).

Кэшировать страницы можно с использованием разных технологий, например, с помощью файла .htaccess или программного обеспечения NGINX. Если для вашего сайта используются именно они, то применить AntiBot.cloud не получится. Стоит обратиться к программисту, чтобы он изменил технологию кэширования.

Скрипт сработает только в том случае, если вы уже заметили накрутку ПФ, но с позициями сайта ещё всё в порядке. Скрипт минимизирует риск атак в следующие сутки, так как неизвестно, когда конкурент решит остановиться. Если позиции упали — скрипт не поможет.

Переклейка 301-м редиректом на новый домен

Переклейка 301-м редиректом будет принудительно переправлять поисковых роботов и посетителей сайта на другие URL-адреса, отличные от первоначальных. Таким образом трафик будет миновать просевший веб-ресурс.

Говорят, что это эффективно не для всех. Но это позволило нам вывести ресурс из-под бана и вернуть ему прежние позиции в выдаче, когда у нас была аналогичная ситуация:

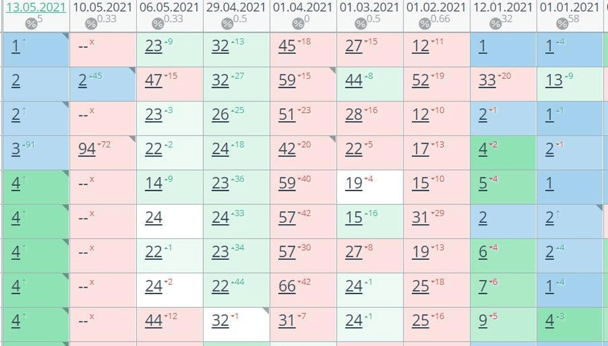

В Топвизоре видно, что в январе сайт находился на первых позициях в выдаче. С конца января началась волна негативных накруток на сайт. В феврале сайт попал под 0 % видимости.

В марте и апреле мы пытались с переменным успехом бороться с этим установкой фильтров, отслеживанием, закупкой трастовых ссылок. Но в итоге в начале мая просто переклеили домен, и к нам вернулись прежние январские позиции.

Метод переклейки 301-м редиректом подходит, если сайт уже упал в выдаче. Тогда необходимо как можно скорее переклеивать его на резервный домен. Этот домен должен у вас отлежаться — быть занятым более 2 лет и иметь хотя бы одну проиндексированную страницу. Такой домен будет иметь большую ценность для поисковых роботов.

Вообще, заведите себе привычку иметь 2-3-4 резервных домена «на всякий случай». Это полезно как раз для подобных ситуаций.

Недостатки

Если переклейка сделана правильно, то в течение недели позиции сайта возвращаются. Однако новый домен необходимо обновить во всех справочниках и каталогах, где раньше был размещен старый домен, а это отнимает дополнительное время.

Другие способы

Скрытие Яндекс.Метрики и Google Analytics от ботов через скрипт

Об этом способе упоминал Дмитрий Севальнев, Евангелист проекта Пиксель Тулс.

Как это работает? Всем пользователям без cookie нашего сайта показывается поп-ап окно. В нём можно просить подтвердить город, согласиться на использование cookie, подтвердить возраст или предложить скидку.

Если пользователь нажимает в этом поп-апе какую-либо кнопку — «Принять», «Отклонить», закрыть — делается вывод, что это живые пользователи, и выполняется отложенная загрузка Яндекс.Метрики и Google Analytics. Если нет — коды метрик не подгружаются.

Мы спросили у Дмитрия, всем ли подходит этот скрипт, нет ли негативного влияния от поп-апов и какие результаты от его применения:

«Мы считаем, что да, данный метод подходит для большинства проектов, так как простое диалоговое окно, которое 95+ % пользователей просто нажимают «на автомате», никого не раздражает. А вот боты и роботы этого НЕ делают. В этом и фишка =)

Все уже привыкли к окнам с уведомлениями об использовании cookie и указанием региона пользователя. Кстати, именно такое уведомление в окне можно объединить с информацией об использовании cookie-файлов на сайте и/или принятием города, который был определён по IP. Убиваем сразу двух зайцев!

Ряд коллег, которые установили скрипт защиты на свой проект, отмечают, что у них наблюдаются снятие санкций и восстановление позиций.

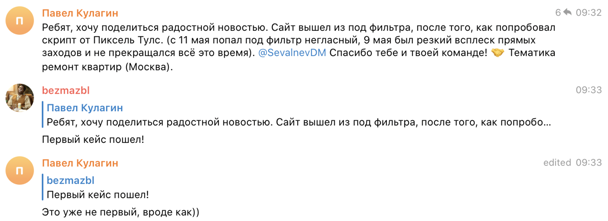

Скрин из нашего чата:

Мы установили скрипт и у себя на проекте, и сейчас уже можно с 99 % вероятностью утверждать, что:

- Метрика и Аналитика правда фильтруется от ботов на 90+ %.

- Показатели по регистрациям не упали.

- Средние показатели вовлечённости аудитории — выросли.

Да, этот скрипт не делает так, что на вашем сайте становится меньше ботов, но статистика становится значительно более чистой и, судя по всему, поисковые системы это тоже ценят».

Вебинар, где Дмитрий подробно описывает метод

Ссылка на скрипт для отложенной загрузки кодов Яндекс.Метрики и Google Analytics от Пиксель Тулс

Обращение в техподдержку Яндекса

Написать в техническую поддержку Яндекса можно, но полагаться на неё не стоит. Она работает по стандартной инструкции: «никаких накруток не бывает, это ваш сайт требует улучшения».

В Справке Яндекс указывает, что влияние накрутки поведенческих конкурентами минимизировано, а если санкции применены, то было за что. Однако 1 % спорных случаев всё-таки был, поэтому списывать техподдержку со счетов не стоит.

Топвизор кое-что нашёл

Есть пример обращения в поддержку по этому вопросу 03.03.2021 г., который нам показал Ян Петручик, основатель digital-агентства «Медиаобраз».

Для начала — подтверждение накрутки:

Его обращение в поддержку:

«Добрый день!

Некоторое время назад позиции моего сайта в поисковой выдаче по самым важным для меня запросам сильно просели. Сейчас я разбираюсь с возможными причинами этой просадки.

В Я.Метрике я узнал, что за период 28.02.2020 - 28.02.2021:

- прямые заходы увеличились с 5 до 2115 в месяц;

- переходы из социальных сетей увеличились с 0 до 469 в месяц.

Из интернет-изданий о поисковом продвижении сайтов и рекламе в интернете, я знаю о том что существует «чёрный» способ продвижения в виде накрутки поведенческих факторов.

Вопросы:

- Учитывая что ни я, как владелец ресурса, ни кто-либо другой с моего указания и позволения, не занимались подобными манипуляциями — можете ли вы объяснить мне природу таких значительных изменений посещаемости именно из этих источников?

- Вне зависимости от того, есть ли возможность установить природу этих посещений, нужно ли мне что-либо предпринимать в связи с увеличением их количества?

- Есть ли применённые к моему сайту санкции которые привели к пессимизации в выдаче (как связанные с этими посещениями, так и нет)?»

Ответ Яндекса:

«Здравствуйте!

- К сожалению, не могу прокомментировать, кто и с какой целью осуществляет подобные посещения.

- При разработке алгоритмов ранжирования предусмотрены случаи, при которых злоумышленники могут попытаться повлиять на позиции того или иного сайта. Поэтому их действия никак не должны отразиться на положении сайта в поиске. Также вам нет необходимости предпринимать дополнительные действия по защите сайта.

- Анализ ранжирования вашего сайта подтвердил, что он занимает позиции, которые соответствуют его текущей релевантности запросам. Также мы проверили корректность работы алгоритмов ранжирования, и в вашем случае мы не видим проблемы, все факторы для сайта учитываются корректно.

Мы постоянно корректируем наши алгоритмы, поэтому сайт может как набирать, так и снижать свои позиции. Также позиции могут меняться не только из-за корректировок алгоритмов, но и по естественным причинам:

- обновление поисковой базы, из-за которой в индекс попадают одни страницы и исчезают другие;

- контент на сайтах меняется;

- меняется релевантная страница с сайта и т. п.

Я понимаю вашу обеспокоенность сложившейся ситуацией, но могу с уверенностью сказать, что с вашим сайтом сейчас всё в порядке и ограничений в его ранжировании с нашей стороны нет. Продолжайте развивать его — это должно положительно повлиять на позиции».

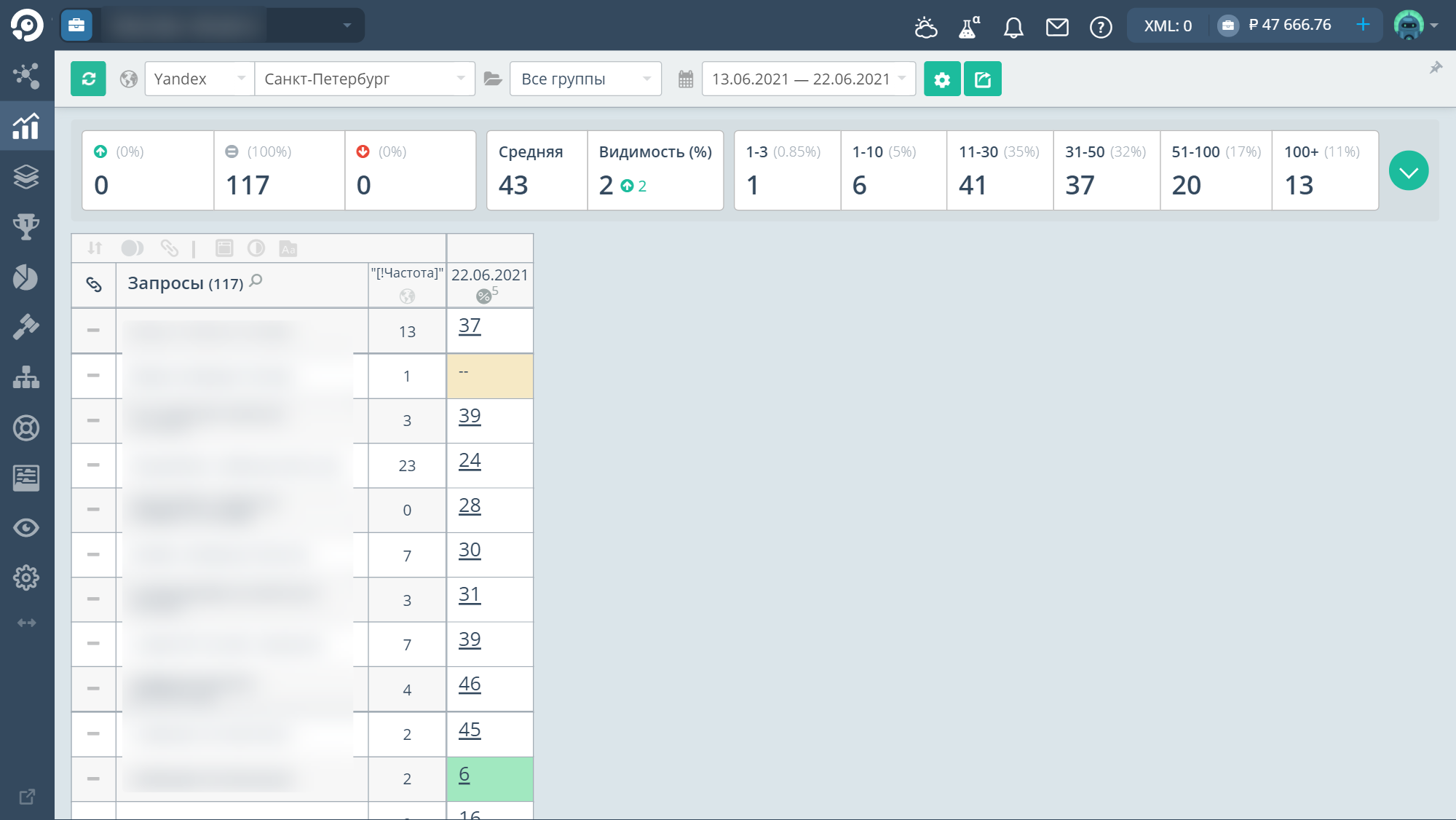

Ян говорит, что накрутка по переходам из соцсетей продолжается по сей день и позиции сайта также пессимизированы. Мы обещали не светить сайт и запросы, но вот текущие позиции:

Случай спорный, поэтому мы попросили Senior SEO-специалиста Владимира Чайковского прокомментировать его. Вот что он думает:

«Яндекс утверждает, что вы не будете наказаны, если конкуренты накручивают вам ПФ. Как Яндекс определяет, что вы крутите не сами? Он смотрит, находились ли вы в тех же сервисах, в тех же местах, что и боты, которыми накручиваются ПФ. Если нет, то это никак не повлияет на сайт.

В то же время, если Яндекс видит, что идёт накрутка, то он понижает сайт в выдаче или временно исключает из индекса. Робот перестаёт находить его, ему подмешивают другую выдачу, накрутка прекращается и позиции постепенно восстанавливаются.

Если говорить про этот случай, то в марте позиции просели у многих, скорее всего, это не связано с накруткой ПФ. Потому что если у сайта есть фильтр за накрутку, то он просто отсутствует в ТОП-100 по всем запросам. Кроме прямого запроса по домену, его больше никак нельзя найти. И даже переклейка 301-м редиректом, по моему опыту, не помогает, потому что фильтр догоняет. А если позиции «болтаются» около ТОП-30, то скорее всего на сайте какой-то понижающий фильтр, и ПФ тут не при чём. На сайте что-то не так. Возможно, переспам.

Нужно проанализировать все страницы. У меня был случай, когда одна страница с переспамом тянула вниз весь сайт. Высушите тексты, уберите лишнее, обратите внимание на элементы и блоки на сайте, которые есть у конкурентов. Возможно, проблема в этом и техподдержка Яндекса права.

В середине июня я тоже обращался с похожим запросом к Платонам. Два сайта сильно просели, при этом взлетела роботность и прямые заходы. Мне ответили то же самое, мол, с сайтом всё хорошо».

Servicepipe

Некоторые SEO-специалисты сказали, что используют сервис Servicepipe. Говорят, он фильтрует не всё, но может стать действенной защитой от наглой накрутки и DDoS.

Мы спросили у Servicepipe, чем он может быть полезен SEO-специалисту в борьбе с накруткой:

«Для веб-сайтов мы предоставляем сервис по защите от DDoS и ботов. Наша технология может определять, кто обращается к ресурсу — бот или реальный пользователь — с самого первого поступившего запроса. Так как защита оказывается с помощью проксирования трафика, мы проводим глубокий технический, поведенческий, статистический анализ, и дополнительно анализируем данные с помощью машинного обучения.

Благодаря всему этому мы можем зафильтровать нелегитимные (ботовые) автоматизированные запросы и защитить сайты от парсинга, искажения метрик, перебора паролей и других вредоносных вещей».

Чего точно не стоит делать

Крутить себе в плюс

Позитивные накрутки работают, но только не в ситуации, когда сайт уже пострадал от негативных накруток. Такое противодействие не сработает и потребует раз в 10 больше ресурсов. На каждое минусовое посещение потребуется с десяток продолжительных переходов.

Важно учитывать и тот факт, что резкий всплеск посещаемости из-за позитивной накрутки Яндекс вычислит и ещё больше «утопит» сайт. Поэтому делать этого не стоит.

Отсекать трафик по странам или другим параметрам

Накрутчики могут заранее вычислить, на какой регион работает сайт, с каких устройств заходят пользователи, и построить под них ботов. Тогда ручная фильтрация трафика отсечёт не только ботов, но и живых пользователей.

Собирать сессии и анализировать их ручным методом

Нельзя сказать, что это не работает, однако метод трудоёмкий и не оправдает потраченных сил.

Так как накрутки чаще всего роботизированные, то каждое посещение бота, которое вы вычислите и запретите по IP, всё равно случится снова с другого адреса. Дело в том, что каждый сервис накрутки поведенческих факторов в обязательном порядке использует прокси, чтобы запутать алгоритмы поисковика.

Устанавливать капчу

Разгадывать капчу крайне неудобно с телефона. Да и с экранов компьютеров некоторые капчи тяжело вводить. Таким образом капча может полностью убить органический трафик. Большинству пользователей легче открыть следующий в выдаче сайт, чем пробовать свои силы в разгадывании символов.

Интересный кейс

Кейс Владимира Чайковского, Senior SEO-специалиста:

«Однажды я выводил 20 сайтов из-под поведенческих. Так вышло, что кто-то из сотрудников решил покрутить ПФ, Яндекс это спалил и под фильтр попали даже те наши сайты, у которых был всего один переход.

Причём трафик с Google остался (накрутка ПФ в Google не так актуальна), а из Яндекса часть сайтов выпала.

Мы перепробовали все варианты: и меняли текст, и ставили ссылки, и переклеивали домены — ничего не помогало. Нам нужно было оставить прежний трафик с Google, а с Яндекс получить новый трафик.

Для этого мы сделали так, что на сервере один сайт открывался на двух доменах. Мы купили похожие домены в .ru, .su, .com и других зонах с тем же самым именем. Для Google мы оставили старый домен, но запретили Яндексу на него заходить. А новый домен запретили обходить всем, кроме Яндекса.

И после этого я увидел, что жирные среднечастотные и высокочастотные запросы через месяц вышли в ТОП Яндекса без ссылок и чего-то ещё. Не все, но 50 % запросов вернулось в ТОП. До ПФ в ТОПе было 70 % запросов.

Сработала текстовая релевантность. Это новорег, ПФ обнулилось, но остался старый удобный сайт на полностью чистом домене. И он за месяц вышел в ТОП, остался там и начал расти. Тогда я понял, что хороший сайт и хороший текст намного важнее для Яндекса, чем ссылки или накрутка ПФ ботами.

Тест был поставлен на примерно 20 сайтов, которые попали под ПФ. Около 15 сайтов вернулось. При том, что некоторые сайты были древние, без нового дизайна, но зашли, потому что сайт удобный, лёгкий, хороший.

Тогда я понял, что ссылки не работают, вернее работают, но не так, как мы ожидали. Если с тематических форумов человек переходит по ссылке — мы получаем естественный ПФ. Если по ссылке был переход, значит, она хорошая. Если не было — сама по себе ссылка никак на продвижение не повлияет».

Если кратко

Накрутка поведенческих факторов сайта — нечестный ход, но иногда этим пользуются. До конца защититься от него невозможно. Хорошая новость в том, что накрутка ПФ ботами по прямым переходам редко влияет на сам сайт. Если позиции понижены и находятся около ТОП-30, то скорее всего это не фильтр. Обратите внимание на текстовую релевантность и качество сайта.

Не устанавливайте капчу и не крутите себе ПФ в ответ на негативную накрутку конкурентов — это ухудшит положение.

Если вы попали под ПФ-фильтр, то как минимум просидите под ним 8-12 месяцев. Поэтому единственный вывести сайт из под фильтра ПФ — зарегистрировать такой же домен в другой зоне, скопировать старый сайт на него, скрыть старый домен от Яндекса и продолжать оптимизацию новорега.