Как сделать качественный SEO-аудит сайта самостоятельно: полное руководство

Что такое аудит сайта по SEO, какие задачи решает и как часто необходимо проводить проверку. Какие инструменты понадобятся. Основные направления проверки и план аудита. Оценка результата, поиск эффективных путей развития проекта и составление отчета.

SEO‑аудит выявляет слабые места сайта и помогает их устранить, а ещё улучшить пользовательский опыт на нём — и, как следствие, продвинуть ваш сайт в результатах выдачи. Рассказываем, зачем ещё нужен аудит и как его делать.

Что такое аудит сайта

Технический аудит сайта — это процесс проверки технического состояния сайта с целью выявления ошибок, проблем и в дальнейшем — улучшения его работы. Аудит обычно проводят с помощью специальных сервисов, однако некоторые показатели анализа можно изучить вручную.

Аудит помогает определить, какие технические проблемы мешают сайту быть успешным и эффективным и как их можно решить.

Вот какие проблемы могут быть выявлены при аудите сайта:

-

неправильная настройка сервера, которая замедляет загрузку страниц сайта;

-

нарушение безопасности сайта — уязвимость в коде или неправильная настройка SSL‑сертификата;

-

проблемы с индексацией сайта ПС — например, когда страницы не индексируются из‑за ошибок в файле robots.txt.

В каких случаях проводится SEO‑проверка

SEO‑аудит сайта следует проводить:

-

При запуске нового сайта. Это поможет убедиться, что сайт оптимизирован для поисковых систем и готов к индексации.

-

При изменении дизайна или переносе сайта на новую платформу. Для уверенности в том, что все элементы сайта (метатеги, ссылки и контент) соответствуют стандартам поисковых систем.

-

При снижении трафика или рейтинга сайта в поисковой выдаче. Чтобы выявить причины и определить методы улучшения ситуации.

-

При запуске новых продуктов или услуг. Это поможет определить, какие ключевые слова и запросы нужно оптимизировать для привлечения целевой аудитории.

-

При запуске новых кампаний контекстной рекламы. Чтобы убедиться, что страницы, на которые ведут рекламные объявления, оптимизированы для поисковых систем и готовы к конверсии.

Что и как нужно анализировать

Показываем, как проводить SEO‑аудит с помощью «Анализа сайта» от Топвизора, а еще Яндекс Вебмастера и Google Search Console.

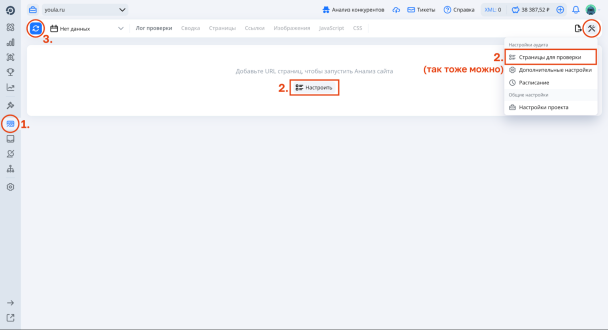

В «Топвизоре» нужно добавить URL для проверки и запустить «Анализ сайта»:

Основные показатели

В начале аудита зафиксируйте:

-

ИКС сайта — индекс качества;

-

количество страниц в индексе Яндекса и Google.

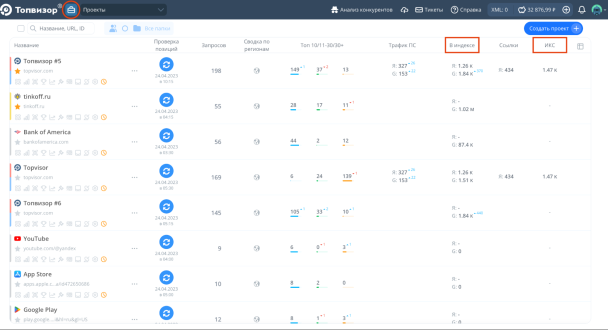

Всё это можно увидеть на главном экране Топвизора в «Проектах»:

Есть ли на сайте санкции, фильтры и вирусы

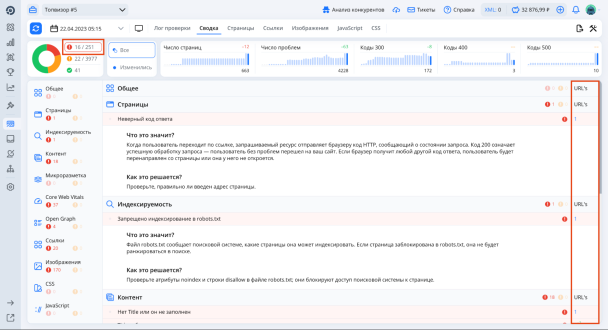

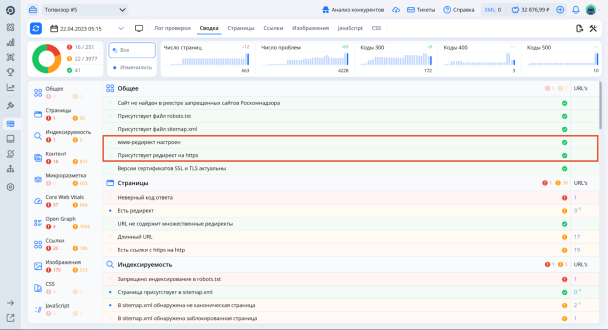

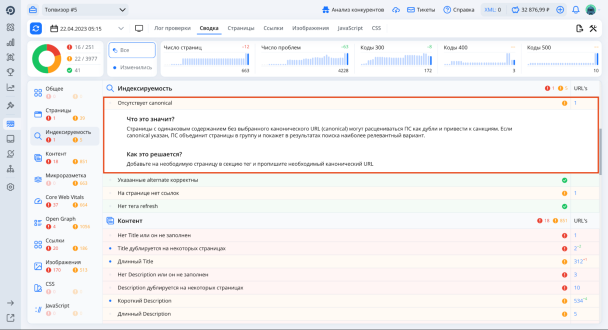

Общую информацию по проверке можно увидеть в «Сводке». Если какие‑то ошибки критичны, «Анализ сайта» подскажет, к чему они могут привести, и даст список проблемных URL. А возможные санкции и фильтры будут выделены красным восклицательным знаком — их можно отфильтровать вверху слева:

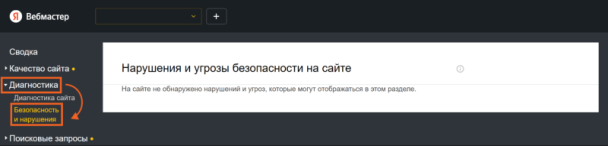

❗️ Нарушения можно увидеть в отчётах Яндекс Вебмастера и GSC. В Яндексе открываем «Диагностика» — «Безопасность и нарушения». Такая картина будет, если никаких нарушений нет:

Если нарушения есть, о них будет написано.

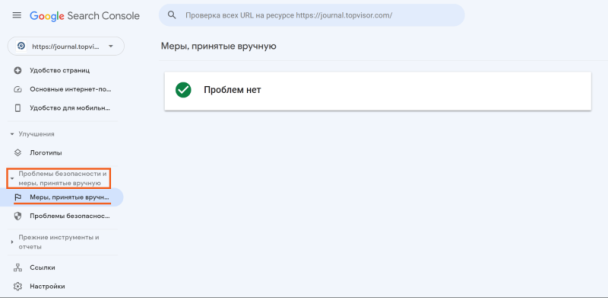

В Google открываем «Проблемы безопасности и меры, принятые вручную» — «Меры, принятые вручную»:

Здесь будут собраны все проблемы, касающиеся фильтров, санкций и других угроз.

Технические ошибки и индексацию сайта

В коде не должно быть ошибок, а у сайта должны быть файлы robots.txt и sitemap.xml.

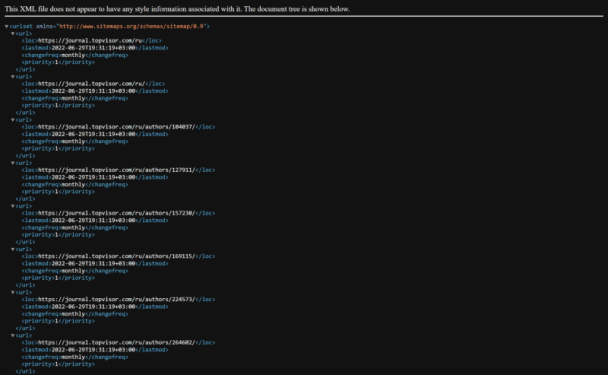

sitemap.xml — это файл, который содержит всю информацию о страницах сайта.

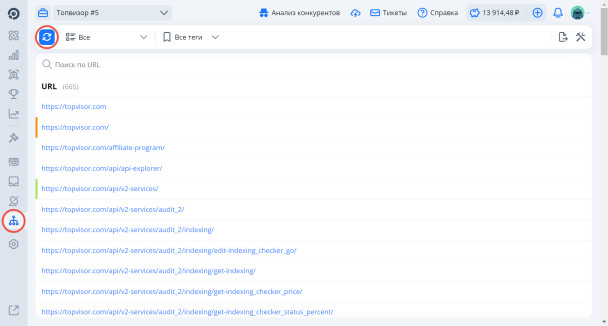

Создать sitemap.xml можно с помощью генератора карты сайта в Топвизоре.

Чтобы сгенерировать карту, переходим в инструмент «Карта сайта» и нажимаем на кнопку «Сгенерировать карту»:

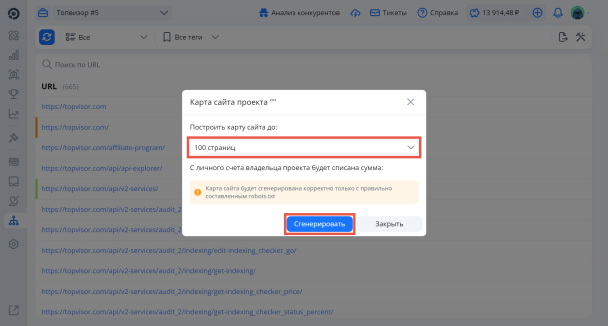

Выбираем размер сайта — максимальное количество страниц, которые сейчас существуют на сайте → нажимаем «Сгенерировать»:

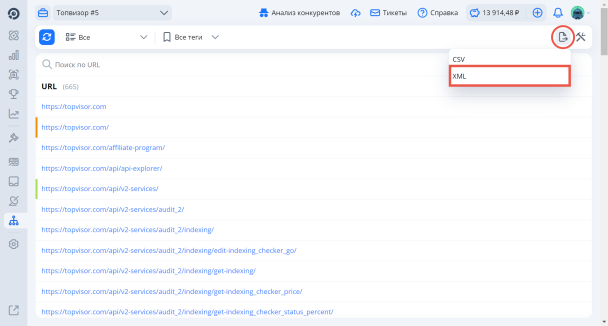

В итоге получим список всех URL сайта. Можно просмотреть их вручную, удалить страницы, которые вы не хотите добавлять в карту сайта, и экспортировать файл в формате xml:

Сгенерированный файл сайта будет выглядеть так:

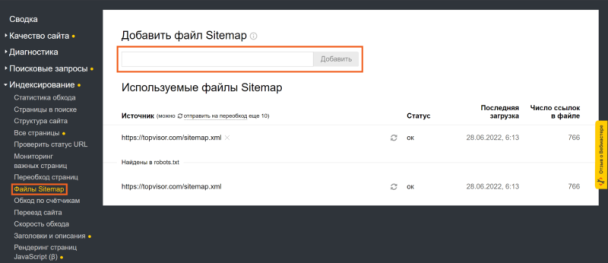

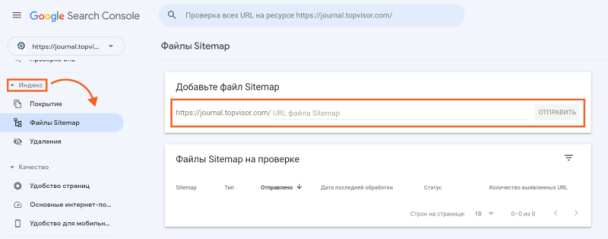

Затем её надо добавить в Вебмастер:

И GSC:

И там же можно будет проверять наличие карты, а также нет ли в ней ошибок, если карта уже создана и добавлена.

Подробнее о том, что такое карта сайта и как с ней работать, читайте в нашем гайде.robots.txt — это текстовый документ формата .txt, в котором прописаны специальные правила (директивы) для поисковых роботов: что сканировать, что не сканировать и многое другое. Директивы помогают управлять индексацией сайта.

Наличие файла проверяется вручную — он либо есть, либо его нет. Хранится файл в корневой папке сайта. Как получить к нему доступ, зависит от вашей CMS.

Как оформлять robots.txt:

-

файл должен называться robots.txt;

-

размер файла не больше 500 КБ;

-

на сайте должен быть только один такой файл;

-

файл размещен в корневом каталоге сайта: https://www.example.com/robots.txt, но не в подкаталоге. Так нельзя: https://example.com/pages/robots.txt;

-

файл отдаёт ответ сервера 200 OK.

После создания и загрузки файла на сайт убедитесь, что он существует, размещён в корневом каталоге сайта и открывается без проблем. Для проверки введите в строку браузера адрес сайта с указанием файла в формате https://site.ru/robots.txt.

После этого можно проверить файл в панелях веб‑мастеров Яндекс Вебмастер и Google Search Console.

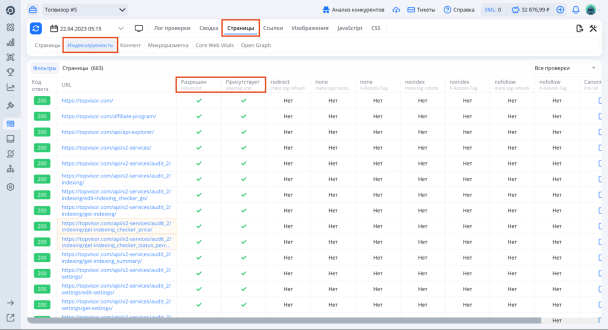

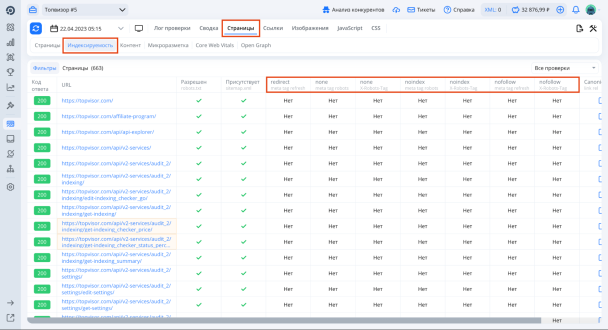

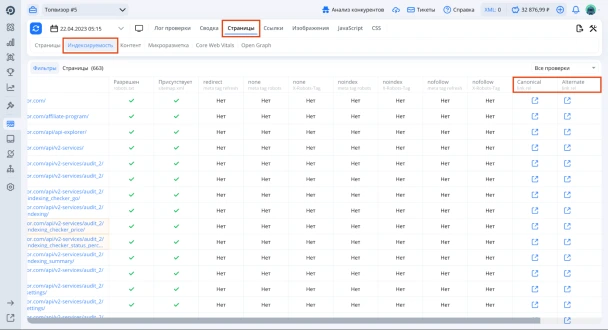

Присутствие страниц в robots.txt и sitemap.xml можно увидеть в Топвизоре: в «Анализе сайта» нажмите «Страницы» → «Индексируемость»:

Индексацией можно управлять с помощью тегов, поэтому при аудите их также нужно проконтролировать.

-

Метатег robots

И файл robots.txt, и этот метатег имеют одну функцию — диктуют поисковым роботам правила индексации страницы. Но метатег относится к данной конкретной странице, а файл — к сайту в целом.

Вот как он выглядит в коде страницы:

<meta name="robots" content="">

С его помощью можно указать роботу, что индексировать, что нет, по каким ссылкам можно ходить, а по каким нет.

-

Атрибут ссылок rel="nofollow"

Нужен, если вы не хотите сказать роботу, что по какой‑то конкретной ссылке не нужно проходить и не нужно учитывать её связь с вашим сайтом.

-

Тег noindex (для Яндекса)

Этот тег позволяет закрыть от индексации элементы на страницах, например дубли контента. Google этот тег не поддерживает.

Убедитесь, что все эти теги присутствуют и прописаны корректно:

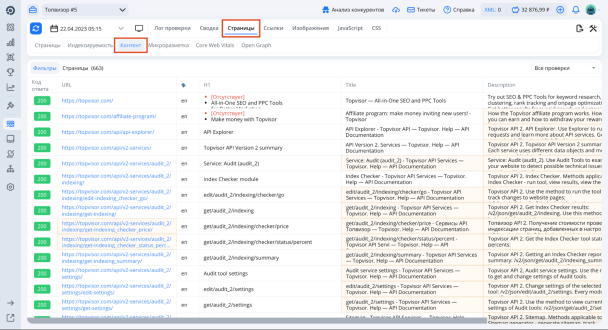

Обязательно проверьте HTML‑разметку — например, наличие на каждой странице H1 и title. Для этого перейдите на вкладку «Страницы» → «Контент»:

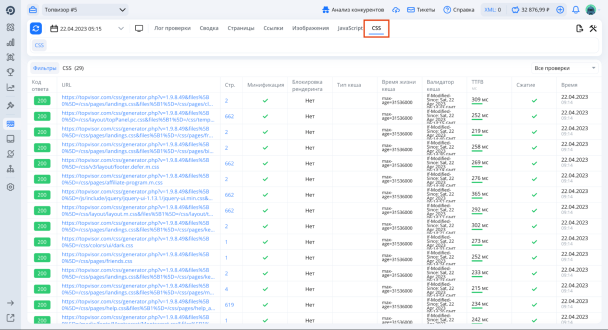

Также важно проверить CSS. Эти данные тоже можно посмотреть как в кратком формате в «Сводке», так и более подробно во вкладке «CSS»:

Какие ещё технические ошибки нужно проверить:

-

URL сайта человекопонятны (ЧПУ). URL должен отражать содержание страницы. «Человекопонятный» значит, что человек смотрит на ваш URL и понимает, о чём эта страница, даже не переходя на неё.

-

У сайта есть мобильная версия, и она работает корректно.

-

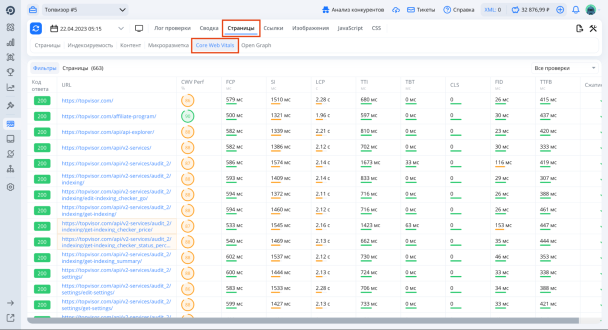

Скорость загрузки и показатели Core Web Vitals оптимальны.

Core Web Vitals — это набор метрик, которые используются для измерения пользовательского опыта на сайтах. Эти метрики измеряют три аспекта пользовательского опыта: скорость загрузки страницы, интерактивность страницы и стабильность отображения страницы при загрузке.

-

Largest Contentful Paint (LCP) — измеряет время, необходимое для загрузки наиболее значимого контента на странице. Оптимальное время загрузки контента — менее 2,5 секунды.

-

First Input Delay (FID) — измеряет время, необходимое для реакции страницы на первое пользовательское взаимодействие, например на нажатие кнопки. Оптимальное время реакции — менее 100 миллисекунд.

-

Cumulative Layout Shift (CLS) — измеряет стабильность отображения страницы при загрузке. Она измеряет, насколько сильно содержимое страницы сдвигается при загрузке, что может привести к нежелательным перемещениям элементов на странице. Оптимальное значение метрики — менее 0,1.

Всё это можно посмотреть на вкладке «Страницы» → «Core Web Vitals»:

-

У сайта нет частичных или полных копий (дубликатов). Сайт должен быть доступен только по адресу с WWW или без него, а не по обоим. Сайт должен использовать один протокол — HTTPS или HTTP, а не оба. Эти данные можно увидеть в «Сводке»:

-

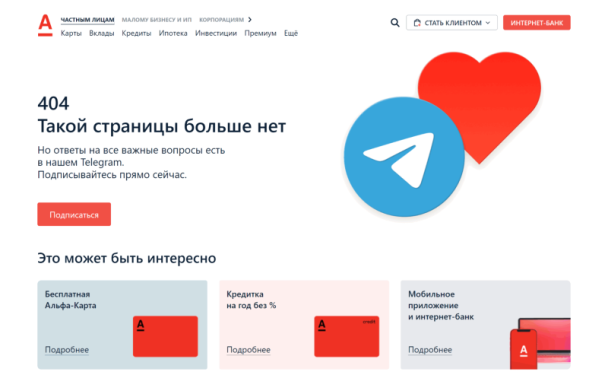

Страницы с кодом ответа сервера 404 Not Found оформлены информативно и полезно для читателя.

Как оформить страницу с ошибкой 404

Качество контента

Качество придётся оценивать вручную. Нужно, чтобы контент на сайте был полезным для посетителей, понятным, релевантным. За спам и SEO‑тексты поисковики могут наложить на сайт санкции.

Структуру сайта

Структура влияет и на удобство для пользователей, и на скорость работы поисковых краулеров, и на ссылочный вес сайта.

Структура должна быть логичной, содержание страниц должно соответствовать названию того или иного раздела, путь от главной до той или иной страницы должен быть не более 3–4 кликов.

Посмотреть свою структуру сайта можно в sitemap.xml, о котором мы рассказали выше.

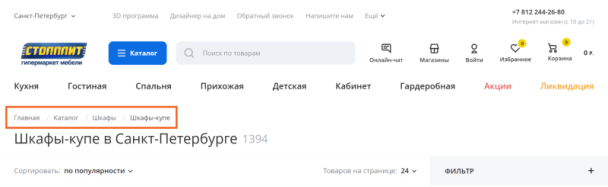

Также проверьте наличие и корректность «хлебных крошек» на сайте. Они нужны, чтобы пользователь мог сориентироваться в иерархии сайта и легко попасть с текущей страницы на уровень выше.

Они находятся либо внутри файла single.php и/или page.php прямо над заголовком страницы, либо в header.php — в конце.

Ссылочный профиль

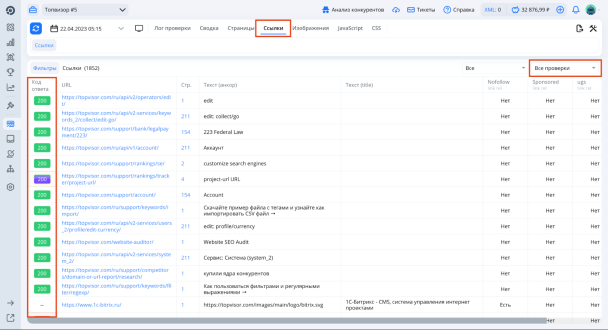

В первую очередь проверяем, что на сайте нет битых ссылок.

Битые ссылки — это ссылки, которые ведут на несуществующие сайты, страницы или файлы. Они обычно отдают код ответа 404 — «Страница не существует».

Чтобы увидеть битые ссылки, перейдите в «Анализ сайта» — «Ссылки». В колонке «Код ответа» отобразятся актуальные коды ответа сервера — вы увидите все страницы с ошибками. А если нажать «Все проверки», можно указать сервису, чтобы он показал только ссылки с ошибками:

Битые ссылки на сайте: как найти и исправить

Также проверьте, что канонические ссылки (rel=‘canonical’) настроены корректно и не ведут сами на себя. Есть canonical отсутствует или не настроен, вы увидите информацию об этом в «Сводке»:

А полный список canonical и alternate можно увидеть на вкладке «Страницы» → «Индексируемость»:

Затем нужно проверить весь ссылочный профиль. Все ссылки (входящие, исходящие, внешние и внутренние) участвуют в формировании ссылочного веса страниц сайта. Поэтому они должны быть тематически подходящими контенту сайта, не быть спамными.

Как провести анализ ссылочной массы сайта: рекомендации и инструменты

Поведенческие факторы

Поведенческие факторы ранжирования — это группа факторов, с помощью которых поисковые системы оценивают поведение пользователей. На основе этой оценки они могут делать выводы:

-

о качестве представленной информации;

-

о качестве сайта и бизнеса в целом;

-

способен ли данный сайт/страница удовлетворить потребность пользователей и если да, то насколько хорошо.

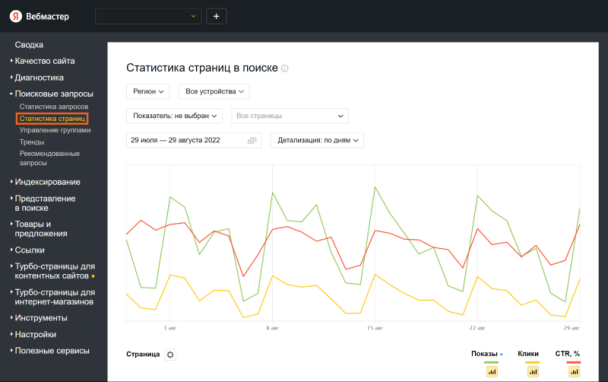

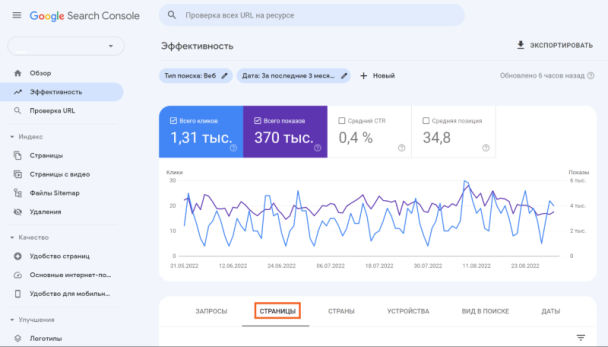

Узнать, как пользователи ведут себя на странице с результатами поиска, можно через Яндекс Вебмастер и Google Search Console.

Вот как посмотреть статистику страниц в поиске и CTR в Яндекс Вебмастере:

В Google:

Ещё нужно посмотреть на поведение пользователей на сайте:

-

отказы;

-

время на сайте;

-

глубину просмотра.

Все эти данные — в Яндекс Метрике и Google Analytics, а по конкретным запросам — в Топвизоре.

Поведение пользователей на сайте — официальная Справка Яндекса

Коммерческие факторы

Коммерческими факторами условно называют факторы, которые:

-

полезны для пользователя;

-

по мнению ПС, положительно влияют на пользовательский опыт и на удовлетворение интента;

-

помогают в совершении целевого действия на сайте, например покупки товара или заказа услуги.

Эти факторы могут учитываться ПС при ранжировании. Во главе угла для ПС — польза для пользователя. Поэтому становится ясно, что нужно отслеживать и коммерческие факторы.

Но чёткого списка или чек‑листа с факторами нет — нам известны только примерные направления факторов. В случае с Яндексом для коммерческих запросов это, например, ассортимент, дизайн, надёжность (доверие к сайту и компании), качество сервиса, удобство использования (юзабилити). Но поисковые алгоритмы постоянно изменяются, так как базируются на машинном обучении.

Совет лишь один: при аудите нужно обращать внимание на все детали на страницах сайта, которые могут хоть как‑то повлиять на поведение пользователей.

Что ещё проверить

-

У сайта есть фавикон (от англ. favorite icon — «любимая иконка»). Он нужен для того, чтобы улучшить вид сайта в поисковой выдаче и повысить его узнаваемость.

Примеры фавиконок

-

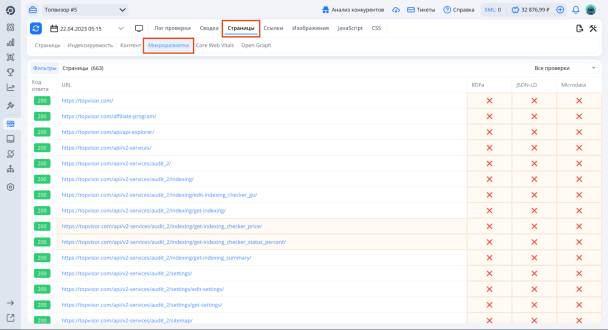

На сайте есть микроразметка. Она может повысить релевантность страницы по целевым запросам. Есть множество типов разметок под разные задачи — для товаров, рецептов, видеозаписей, FAQ. Чаще всего специалисты используют микроразметку Schema.org. Смотрим микроразметку в «Анализе сайта» от Топвизора:

-

Сайт есть в Google My Business и Яндекс Справочнике — это особенно касается локального бизнеса.

-

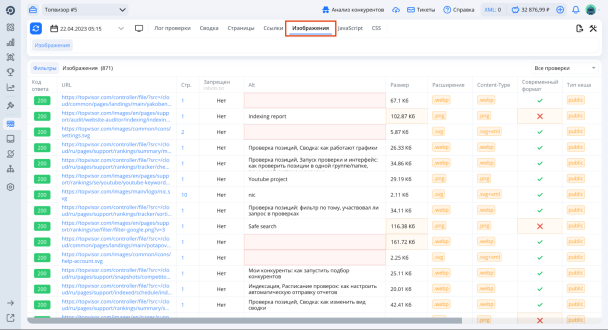

У всех изображений на сайте есть атрибут alt, сами изображения оптимизированы и загружаются быстро. Проверить это тоже можно в Топвизоре:

Отмечайте в чек‑листе, что у вас уже есть, а над чем ещё нужно поработать — и добавляйте это в планы по оптимизации.

Как оценить результаты и составить план по оптимизации

Когда вы проводите аудит, лучше всего фиксировать результаты проверки каждого аспекта там, где вам удобно: например, в Google‑документе или таблице, на странице в Notion.

Когда аудит будет проведен, у вас сформируется план действий для корректировки положения сайта в выдаче ПС.

❗️Так могут выглядеть результаты аудита сайта:

Показатели сайта

В Google и Яндексе у сайта разное количество страниц в индексе. Стоит обратить внимание на работу с Яндексом в первую очередь.

Индексация сайта

Файл robots.txt существует, но неправильно настроен — в индекс попали служебные страницы. Стоит закрыть их для индексации директивой в файле.

Ссылочный профиль

Удалить битые ссылки со следующих страниц. Сформировать список анкоров, содержащих высокочастотные запросы, чтобы как можно скорее использовать их для формирования ссылочного профиля.

Поведенческие факторы

Уникализировать title и description на всех страницах сайта, чтобы улучшить CTR в выдаче за счёт привлекательного сниппета.

Прочие рекомендации по работам с сайтом

-

Улучшить скорость загрузки сайта.

-

Добавить сайт в Google My Business.

-

Добавить на страницы с товарами микроразметку.

❗️ Конечно, в реальном аудите, который вы будете делать для своего сайта или для проекта клиента, будет больше конкретики, могут добавиться или удалиться какие‑то разделы — всё зависит от того, что вы выясните в ходе аудита.

В результаты аудита и рекомендации можно прикреплять скриншоты страниц с ошибками и прочего, ссылки и другие комментарии.

Чтобы составить план по оптимизации, нужно опираться на существующую стратегию сайта и на очерёдность действий.

Как правило, стоит начать с наиболее критичных аспектов оптимизации: исправить технические ошибки, удалить битые ссылки, наладить работу sitemap и robots.txt. Затем можно заняться качеством контента сайта, формированием ссылочного профиля и поработать с поведенческими и коммерческими факторами ранжирования.

Что ещё почитать

Как разработать стратегию продвижения сайта для SEO: инструкция с примерами

Александр Бурлай о том, как зарабатывать на SEO‑аудитах

Подборка лучших ресурсов по SEO: книги, подкасты, каналы